En el ámbito de la medicina intensiva, el aumento de la supervivencia ha venido de la mano de la mejora de los cuidados, la detección precoz del deterioro clínico y la prevención de la iatrogenia, mientras que la investigación de nuevos tratamientos se ha seguido de una abrumadora serie de decepciones. Las raíces de estos fracasos hay que buscarlas en la conjunción de problemas metodológicos —comunes a otras disciplinas— y las particularidades de los pacientes críticos. En este artículo se exploran ambos aspectos y se sugieren algunas vías de progreso.

In the field of Intensive Care Medicine, improved survival has resulted from better patient care, the early detection of clinical deterioration, and the prevention of iatrogenic complications, while research on new treatments has been followed by an overwhelming number of disappointments. The origins of these fiascos must be sought in the conjunction of methodological problems - common to other disciplines - and the particularities of critically ill patients. The present article discusses both aspects and suggests some options for progress.

La finalidad última de la investigación clínica es la mejora del estado de salud de las personas. Para conseguir este objetivo, los estudios sobre intervenciones terapéuticas y preventivas deberían idealmente1 abordar un objetivo relevante para la toma de decisiones clínicas2; realizarse de acuerdo con una metodología apropiada que minimice tanto el error aleatorio como el error sistemático3; difundirse de forma íntegra y en un formato adecuado para el decisor, y aplicarse de forma juiciosa en la atención al paciente (fig. 1)4. La rotura de alguno de estos 4 eslabones de la cadena supone un desperdicio de investigación1-3.

De acuerdo con los datos disponibles, el volumen de esta investigación desperdiciada es considerable: entre un 30 y un 50% de los ensayos aleatorizados presentan fallos metodológicos importantes1,4; la tasa de no replicabilidad de los estudios es superior al 50%5-8; gran parte de la investigación disponible es inservible1,9-11, y un 40% de los pacientes en un momento dado no reciben tratamientos reconocidos como eficaces con el estado actual de la ciencia2,12,13.

En el ámbito de la medicina intensiva se han producido importantes logros, como la reducción de la mortalidad del síndrome de distrés respiratorio agudo (SDRA)14 o la sepsis15. Sin embargo, estos avances han venido de la mano de la mejora general de los cuidados, la detección precoz del deterioro clínico y la prevención de la iatrogenia16,17, mientras que un gran número de ensayos aleatorizados esperanzadores han concluido con resultados negativos o con un aumento inesperado de la mortalidad18-23 (tabla 1). Esta situación ha dado pie a que algunos influyentes investigadores hayan cuestionado la normativa europea sobre ensayos clínicos24 e incluso la propia idoneidad de los ensayos aleatorizados en cuidados intensivos17,25-28.

Estudios en pacientes críticos que han reportado aumento de la mortalidad en el grupo experimental

| Estudio (año) | Intervención | Pacientes | RR de mortalidad |

|---|---|---|---|

| Hayes et al. (1994)113 | Aumento aporte de oxígeno | Pacientes críticos generales | Mortalidad hospitalaria RR 1,58 (IC del 95% 1,01, 2,56) |

| Takala et al. (1999)19 | Hormona del crecimiento | Pacientes críticos generales | Mortalidad hospitalaria (subestudio multinacional) RR 2,4 (IC del 95% 1,6 a 3,5) |

| Finfer et al. (2009)23 | Control estricto de glucemia | Pacientes críticos generales | Mortalidad a los 90 días OR 1,14 (IC del 95% 1,02 a 1,28) |

| Gao Smith et al. (2012)20 | Agonistas ß-2 | SDRA bajo ventilación mecánica | Mortalidad a los 28 días RR 1,47 (IC del 95% 1,03 a 2,08) |

| Perner et al. (2012)22 | Hidroxietilalmidón | Sepsis grave | Mortalidad a los 90 días RR 1,17 (IC del 95% 1,01 a 1,36) |

| Ferguson et al. (2013)21 | Ventilación oscilatoria de alta frecuencia | SDRA moderado-grave | Mortalidad hospitalaria RR 1,33 (IC del 95% 1,09 a 1,64) |

| Heyland et al. (2013)73 | Glutamina | Pacientes críticos con ventilación mecánica y fallo multiorgánico | Mortalidad ajustada a los 28 días OR 1,28 (IC del 95% 1,0 a 1,64) |

IC del 95%: intervalo de confianza del 95%; OR: odds ratio; RR: riesgo relativo; SDRA: síndrome de distrés respiratorio agudo.

En este primer artículo de la serie Metodología de investigación en el enfermo crítico se abordan las deficiencias de la «cadena de la investigación» que podrían explicar —al menos en parte— los fracasos de los estudios de efectividad comparada (EEC) en cuidados intensivos; a continuación se examinan con más detenimiento las singularidades de la investigación clínica en pacientes críticos que podrían contribuir a estos fiascos; finalmente, se apuntan posibles vías de progreso. Otros problemas metodológicos, la investigación con big data29 y los aspectos ético-legales de la investigación, serán tratados en otros artículos de la serie.

Desenlaces relevantesLa investigación preclínica es esencial para la comprensión de la fisiopatología y el desarrollo de tratamientos eficaces para el manejo del enfermo crítico30. Por ejemplo, la demostración de la lesión pulmonar aguda en modelos animales ventilados con volúmenes altos31 se pudo trasladar con éxito a la clínica y fue la base de la actual ventilación protectora14. Sin embargo, hasta un 75-90% de los resultados de la investigación preclínica publicados en revistas de alto perfil —habitualmente evidencias de tipo etiológico o fisiopatológico— no son reproducibles7 y, hasta la fecha, solo una mínima parte se ha traducido en innovaciones sustanciales para su uso a la cabecera del paciente32.

Al igual que la investigación preclínica, la investigación clínica tradicional se centra en el análisis de manifestaciones biológicas de la enfermedad (v.g. el gasto cardiaco o los niveles plasmáticos de citocinas). El problema es que la literatura científica ha mostrado reiteradamente una disociación entre estos resultados fisiopatológicos (de interés para el investigador) y los resultados clínicos (que realmente importan al paciente). El fracaso de la estrategia del aporte supranormal de oxígeno33 o el más reciente de la reanimación hemodinámica precoz orientada a objetivos34,35 son solo 2 de los más conocidos ejemplos.

Desde la perspectiva de una investigación clínica centrada en el paciente36, estos desenlaces deben ser considerados como desenlaces subrogados (o evidencia indirecta) de los desenlaces clínicos verdaderamente importantes para la toma de decisiones, como la supervivencia, la extubación tras la ventilación mecánica, la calidad de vida tras el alta hospitalaria o los costes37. Si esa evidencia indirecta no se traduce en una mejora de los desenlaces clínicos importantes ello supondrá un desperdicio de investigación.

Otra forma de investigación inútil ocurre cuando un estudio se plantea una pregunta de investigación con desenlaces clínicos importantes, pero sobre la que ya existe evidencia científica satisfactoria para contestarla1,38. En efecto, se ha estimado que el 50% de los estudios se diseñan sin referencia a revisiones sistemáticas previas39, con el consiguiente riesgo de generar publicaciones redundantes. Por ejemplo, Fergusson et al.40 identificaron mediante un metaanálisis acumulativo 64 ensayos publicados entre 1987 y 2002, demostrando que la efectividad de la aprotinina quedó claramente establecida en 1992 tras la realización del decimosegundo ensayo; los siguientes 52 ensayos, por tanto, se habrían podido evitar con una adecuada revisión sistemática. Esta investigación redundante, además de innecesaria, es éticamente cuestionable y ha generado una movilización de la sociedad civil y de algunas agencias financiadoras para exigir la realización de revisiones sistemáticas sobre el tema antes de iniciar un nuevo ensayo clínico3,41,42.

Se ha debatido extensamente acerca de cuál es el desenlace clínico más adecuado para los ensayos clínicos en pacientes críticos18,43-46. La mortalidad por cualquier causa es el desenlace relevante por excelencia. En cualquier caso, la mortalidad debería referirse a un plazo adecuado a la patología en estudio (p. ej., mortalidad a los 28 días o a los 90 días)45 y tener en cuenta el posible impacto de la limitación de los tratamientos de soporte vital.

Una de las dificultades de la mortalidad es su carácter dicotómico, que aumenta considerablemente las necesidades de tamaño muestral, especialmente en situaciones de baja incidencia. Este problema se ha intentado paliar con el desarrollo de resultados combinados (composite endpoints), como la aparición de «muerte, infarto o reperfusión urgente» o «muerte o disfunción orgánica»47. Sin embargo, los desenlaces combinados son a veces de difícil interpretación, son fácilmente manipulables por el investigador y favorecen una visión demasiado optimista de los resultados, por lo que su interpretación debe ser cautelosa48,49. Por ejemplo, la utilización del desenlace combinado «muerte, infarto o reperfusión urgente» tendría poco sentido si las diferencias observadas se debieran exclusivamente a las diferencias de reperfusión.

La mortalidad no es el único desenlace relevante para el paciente. Aspectos como la duración de la estancia en la UCI, el número de días sin ventilación mecánica o la calidad de vida tras el alta hospitalaria50 son otros desenlaces importantes que deberían ser tenidos en cuenta por las guías de práctica clínica para el establecimiento de recomendaciones.

En los estudios comparativos de antimicrobianos en pacientes críticos, los desenlaces clínicos tradicionales presentan serias limitaciones. Por ejemplo, la mortalidad puede deberse solo parcialmente al proceso infeccioso. El cálculo de la mortalidad atribuible puede ser más útil que la mortalidad cruda cuando coexisten varias causas de muerte y comorbilidad51. Sin embargo, hay que recordar que el riesgo atribuible no mide la fuerza de la asociación (como el riesgo relativo o la reducción relativa del riesgo), sino que es una medida de impacto, cuyo valor depende del riesgo basal de los pacientes. Otros desenlaces habituales, como la tasa de curación clínica o la duración de la infección, conllevan un importante grado de subjetividad, ya que los síntomas pueden ser debidos a otros eventos intercurrentes. Por otra parte, los estudios comparativos de estrategias antimicrobianas requieren la valoración conjunta de desenlaces relevantes para el enfermo (mortalidad, curación, efectos adversos) con otros relevantes para la sociedad (duración del tratamiento, aparición de resistencias). La metodología Desirability Of Outcome Ranking/Response Adjusted Days of Antibiotic Risk (DOOR/RADAR) permite comparar la distribución de estos desenlaces de forma conjunta, lo que obviaría algunos de los problemas de los estudios de no inferioridad, habituales en este campo52,53. Aunque ha sido propuesta como metodología de elección para el análisis coprimario de estudios de mejora de estrategias antibióticas, esta metodología comparte las limitaciones de los estudios con resultados combinados, su interpretación es susceptible de manipulación por parte del investigador y un resultado positivo no siempre descarta la no inferioridad del tratamiento experimental54,55.

Estudios pequeñosLa falta de potencia estadística para detectar efectos razonables podría explicar buena parte de los resultados negativos obtenidos en los estudios realizados en pacientes críticos56,57.

Harhay et al.57 revisaron los ensayos aleatorizados realizados en UCI publicados en 16 revistas de alto impacto. De los 40 estudios que analizaban la mortalidad, 36 fueron negativos y solo 15 tenían tamaño suficiente para detectar una reducción absoluta de la mortalidad del 10%. Uno de los factores determinantes de estos resultados fue un cálculo del tamaño muestral inadecuado basado en una estimación del efecto demasiado optimista. Ello suscita un problema ético, en la medida en que se somete a pacientes a una experimentación que no cuenta con los recursos suficientes para cumplir sus objetivos58. Por otro lado, una parte de estos resultados negativos podría tratarse de «falsos negativos», lo que podría desanimar la realización de futuros estudios en un campo prometedor.

Paradójicamente, además de propiciar el error de tipo ii (falsos negativos), los estudios pequeños favorecen la obtención de falsos positivos que posteriormente no son confirmados en ulteriores estudios. En efecto, cuando el número de pacientes es pequeño (p. ej., al inicio de la fase de reclutamiento de un ensayo) la estimación del efecto es muy inestable y produce frecuentemente resultados espurios (falsos positivos y falsos negativos)59,60.

Típicamente estos falsos positivos («máximos aleatorios») coinciden con una estimación de efecto implausible61.

Los máximos aleatorios característicos de los estudios pequeños podrían explicar gran parte de los fiascos de la investigación en cuidados intensivos. Por ejemplo, en un ensayo aleatorizado realizado en pacientes postoperados de pancreatitis grave se asignó a 30 pacientes a nutrición yeyunal precoz (dentro de las 12h de la cirugía), mientras que los 30 restantes sirvieron de grupo control. La mortalidad fue del 3,3% en el grupo experimental y del 23% en el grupo control (riesgo relativo 0,14; intervalo de confianza del 95% [IC del 95%] 0,02-0,81; p = 0,03)62. Al margen de posibles sesgos, estos resultados nos deberían alertar en un doble sentido. Primero, parece poco verosímil que el inicio de la nutrición enteral en las primeras 12 h reduzca la mortalidad en un 86% (riesgo relativo de 0,14). Segundo, el tamaño muestral calculado para detectar un efecto «razonable» del 30% (con un nivel de significación del 5% y un poder estadístico del 80%) es de 518 pacientes por grupo. El bajo tamaño muestral (por debajo del tamaño óptimo de información63) y la magnitud implausible del efecto indican fuertemente que estamos ante un máximo aleatorio. Esta impresión fue corroborada por un metaanálisis posterior64 basado en 12 ensayos y 662 pacientes que comparaban nutrición enteral precoz frente a tardía en pacientes críticos generales que no encontró diferencias de mortalidad significativas (riesgo relativo 0,76, IC del 95% 0,52-1,11).

Por último, los estudios pequeños con frecuencia presentan problemas metodológicos que los hacen más propensos a los sesgos, lo que podría contribuir a la sobreestimación del efecto.

Existe evidencia empírica de que esto ocurre en el ámbito de la investigación en el enfermo crítico. Así, Zhang et al.65 examinaron 27 metaanálisis (317 estudios) de ensayos realizados en pacientes críticos que analizaban la mortalidad y comprobaron que los estudios pequeños (con menos de 100 pacientes por brazo) eran de peor calidad en aspectos como la generación y la ocultación de la secuencia de aleatorización, pérdidas en el seguimiento, análisis por intención de tratar o enmascaramiento y, considerados globalmente, sobrestimaban el efecto en un 40%.

El problema de los estudios pequeños está íntimamente ligado al de la interrupción precoz del ensayo por beneficio. Frecuentemente, durante la realización de un ensayo clínico se realizan análisis intermedios para prevenir el reclutamiento de nuevos enfermos cuando existe evidencia clara de superioridad, toxicidad o futilidad. Esta práctica abre la posibilidad de detener el estudio ante un máximo aleatorio (con la consiguiente sobreestimación del efecto)66,67. Un ejemplo ilustrativo es el estudio OPTIMIST68 en el que se analizaba el efecto de tifacogin en pacientes con sepsis grave y coagulopatía. Un primer análisis intermedio con los primeros 722 pacientes reclutados detectó una reducción significativa de la mortalidad en el grupo experimental (29,1% frente al 38,9%; p = 0,006), que desapareció en el análisis final tras reclutar a 1.754 pacientes (34,2% frente a 33,9%; p = 0,88).

SubgruposLos ensayos proporcionan resultados promedio de la efectividad del tratamiento sobre el conjunto de los enfermos incluidos en el estudio. Sin embargo, no todos los pacientes incluidos en el estudio se benefician del tratamiento: algunos pacientes presentan los efectos adversos del tratamiento («perjudicados»), otros presentan el evento a pesar del tratamiento («condenados») y otros, finalmente, no habrían presentado el evento en ningún caso, por lo que el tratamiento habría sido superfluo («inmunes»)69. El análisis de los resultados estratificados por datos demográficos, niveles de gravedad o comorbilidad facilita la identificación de los subgrupos que más se pueden beneficiar o sufrir daño como consecuencia del tratamiento.

Con todo, la distribución homogénea de las variables pronósticas entre los distintos brazos del ensayo dentro de cada subgrupo no está garantizada y el análisis de subgrupos conlleva importantes riesgos70. En un reciente estudio metaepidemiológico70 solo 46 de los 117 subgrupos declarados estaban apoyados en sus propios datos; solo 5 de estos 46 hallazgos de subgrupos tuvieron al menos un intento de corroboración y ninguno de los intentos de corroboración alcanzó una p significativa en el test de interacción.

Otros problemas metodológicos de los ensayos en pacientes críticos —como la generación y ocultación de la secuencia de aleatorización, el sesgo de desgaste o el enmascaramiento— se analizan detenidamente en otros artículos de la serie.

Difusión selectiva o inadecuada de resultadosPara que la investigación de efectividad comparada sea útil no basta con que sea relevante y esté bien diseñada y ejecutada. Es preciso además que la evidencia generada llegue al decisor clínico y que este la aplique en sus pacientes.

Se estima que un 50% de los estudios realizados no llegan a publicarse como artículo1 y la parte que finalmente se publica sobrerrepresenta los estudios con resultados positivos e infrarrepresenta los efectos adversos de los tratamientos (sesgo de publicación). Por ejemplo, los suplementos de glutamina fueron recomendados en su día por algunas guías de práctica clínica en pacientes traumatizados y quemados71; posteriormente, un metaanálisis Cochrane en pacientes críticos generales detectó indicios de sesgo de publicación72 y un ensayo amplio bien diseñado encontró un aumento de la mortalidad en pacientes críticos con fallo multiorgánico73.

Las raíces del sesgo de publicación habría que buscarlas en la resistencia de los promotores a publicar resultados desfavorables, amparados en una normativa permisiva con la ocultación de los resultados de los estudios74, junto con la tendencia de los editores de revistas a publicar preferentemente estudios con resultados positivos. Sin embargo, diversos estudios indican que los propios investigadores ejercen una especie de autocensura que favorece la no publicación de los resultados negativos74. La gravedad del problema ha propiciado algunas iniciativas —como Alltrials75 o James Lind41— que favorecen la publicación de toda la evidencia disponible y animan a los pacientes a que no participen en ensayos que no garanticen la publicación total de los resultados3,75.

Por otro lado, no todos los desenlaces que se estudian son los que finalmente se publican, lo que genera una especie de «sesgo de publicación intraestudio». Chan et al.76 comunicaron que en el 62% de los estudios cuyo protocolo había sido previamente registrado el artículo finalmente publicado presentaba al menos un desenlace primario cambiado, introducido u omitido; y además, los desenlaces estadísticamente significativos tenían mayor probabilidad de ser comunicados que los no significativos. Por ejemplo, en un estudio comparativo de fluidoterapia con salino frente a hidroxietilalmidón (HES) en un grupo de pacientes traumatizados77 se concluyó que «el HES genera menos daño renal y un aclaramiento de lactato significativamente mejor que el suero salino». En el registro previo del ensayo (http://www.isrctn.com/ISRCTN42061860) los autores habían señalado 2 outcomes primarios y 7 desenlaces secundarios. Sin embargo, como señalan Reinhart y Hartog78, 3 de los desenlaces publicados no figuraban en el registro, entre ellos el daño renal agudo y el aclaramiento del lactato, que constituyen los principales resultados del artículo. Esta comunicación selectiva de los resultados tiende a aumentar los falsos positivos y contribuye a la sobreestimación del beneficio de los tratamientos que se publican en la literatura médica.

Por último, aunque se publiquen, los resultados pueden presentarse de forma manipulada o poco transparente, lo que dificulta su replicación, y complica la valoración de su validez y aplicabilidad, convirtiéndolos en inservibles79. Es bien conocido que los ensayos promovidos por la industria farmacéutica sobreestiman de forma muy importante la efectividad del tratamiento experimental en comparación con los estudios promovidos por entidades sin ánimo de lucro («sesgo de promotor»)80. El problema se ha agravado en los últimos años debido a la proliferación de las llamadas «publicaciones depredadoras», un modelo de negocio basado en revistas de acceso gratuito que se financian con las tasas de los autores sin una adecuada revisión por pares ni otras medidas de control de la calidad81-83.

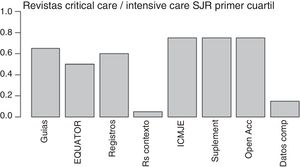

La cada vez más frecuente solicitud a los autores por parte de las revistas de los datos crudos para que puedan ser revisados por los expertos estadísticos y la propuesta del Instituto de Medicina (IOM)84 de facilitar el análisis compartido de los datos primarios de los ensayos aleatorizados parecen marcar un camino prometedor que podría abordar algunas de las deficiencias actuales y reducir el desperdicio de la investigación. Esta última propuesta ha sido recientemente recogida por el Comité Internacional de Editores de Revistas Médicas (ICMJE)85, si bien solo la cumple una minoría de las revistas de medicina intensiva (fig. 2).

Iniciativas de las revistas de cuidados intensivos para mejorar la cadena de la investigación.

Medidas para reducir el desperdicio de la investigación incluidas en las normas para los autores de las revistas de cuidados intensivos indexadas por SJR dentro del primer cuartil (año 2015). De izquierda a derecha: menciona alguna guía de presentación de los resultados; menciona algunas de las guías de EQUATOR; menciona el registro previo de ensayos o revisiones sistemáticas; sugiere revisiones sistemáticas para contextualizar artículos originales; recomienda consultar la web del ICMJE; permite la publicación online de material suplementario; cita alguna forma de acceso gratuito; formula alguna política para favorecer el uso compartido de datos.

Datos comp: datos compartidos; EQUATOR: Enhancing the QUAlity and Transparency Of health Research; ICMJE: International Committee of Medical Journals Editors; Open Acc: Open Access; RS: revisiones sistemáticas; Suplement: material suplementario; SJR: Scimago Journal Reports.

Por último, uno de los avances más importantes de los últimos años en la difusión de los resultados de la investigación clínica es la iniciativa EQUATOR86, que ha generado guías para la publicación de diversos tipos de estudio, como CONSORT (para ensayos clínicos), PRISMA (para metaanálisis) o STARD (para estudios de diagnóstico), que favorecen una mayor trasparencia de los resultados, permitiendo al lector valorar por sí mismo la credibilidad de los resultados86. Desafortunadamente, el número de revistas del campo de la medicina intensiva que recomiendan el uso de estas guías es todavía escaso (fig. 2).

Aplicación de los resultadosEl cuarto eslabón de la cadena de la investigación lo constituye la decisión de aplicar o no los resultados de la evidencia científica. Se trata del salto desde la evidencia obtenida a partir de grupos de pacientes seleccionados (de los que frecuentemente se ha excluido a los pacientes con comorbilidad) bajo condiciones asistenciales óptimas, hasta la decisión clínica en el paciente individual (con su propia comorbilidad y preferencias) en un entorno asistencial distinto87,88.

Las guías de práctica clínica basadas en la evidencia proporcionan una ayuda para establecer recomendaciones individuales. Actualmente, la metodología de la aproximación Grading of Recommendations Assessment, Development and Evaluation (GRADE) está considerada como la principal referencia para establecer el grado de evidencia y la fuerza de la recomendación89,90. Sin embargo, no todas las guías de práctica clínica son igualmente confiables. La aplicación acrítica de antiguas jerarquías de la evidencia basadas en un solo desenlace clínico, que equiparaban de forma automática ensayo aleatorizado con evidencia de calidad alta, llevó a considerar que la hemofiltración de alto flujo en la sepsis estaba respaldada por evidencia de alta calidad, llegándose a afirmar la obligatoriedad de su aplicación en cualquier paciente con fracaso renal agudo91. Habría que esperar algunos años hasta que estudios ulteriores acabaran demostrando que la terapia de alto flujo era fútil92.

Dificultades añadidas de los estudios de efectividad comparada en el paciente críticoA las deficiencias anteriores, comunes a otras disciplinas, se añaden las peculiaridades de la investigación en el paciente crítico, que complican en gran medida la realización e interpretación de los estudios.

El primer rasgo destacable es la gran heterogeneidad de pacientes incluidos en los ensayos. Los diagnósticos habituales de los pacientes críticos (como SDRA o sepsis) son en realidad síndromes, necesitados de redefiniciones periódicas93,94, en los que se incluye una gran variedad de patologías. Como muestra, menos de la mitad de los diagnosticados de SDRA con los criterios de la definición de Berlín93 tienen en la autopsia lesión pulmonar difusa, el clásico correlato anatomopatológico del SDRA95. A esta heterogeneidad entre pacientes se añade la fisiopatología rápidamente cambiante de la enfermedad dentro del mismo paciente, como ocurre en la sepsis. En estas condiciones parece poco razonable esperar que un único tratamiento sea efectivo para distintas formas de SDRA o que sea igualmente efectivo en una sepsis en fase hiperinflamatoria que en una sepsis en estadio de déficit inmunitario26,27.

En segundo lugar, en el paciente crítico concurren una gran variedad de tratamientos y una alta prevalencia de comorbilidad, con la consiguiente probabilidad de interacciones y de aplicación de procedimientos diagnósticos o terapéuticos adicionales (cointervención), a veces en forma sutil96-99.

Por último, la vigilancia intensiva y los ajustes continuos de los tratamientos inherentes a los cuidados intensivos suponen una dificultad adicional para diseñar un grupo control adecuado, que refleje la práctica clínica habitual. En efecto, los tratamientos en UCI se dosifican frecuentemente de forma flexible según la situación del paciente (v.g. según los cambios hemodinámicos o de la mecánica pulmonar). Si estas intervenciones se fijan mediante un protocolo estricto se pueden crear en ambas ramas del ensayo subgrupos de pacientes que reciben dosis de tratamiento inconsistentes con la práctica habitual. Este desajuste con la práctica clínica habitual (practice misalignment)25,100, además de comprometer la validez externa del estudio, genera nuevos problemas de interpretación y podría perjudicar a algunos enfermos.

Por ejemplo, en el ensayo Acute Respiratory Distress Syndrome (ARDS) Clinical Trials Network low-tidal-volume (VT) trial (ARMA)14 una serie de pacientes con SDRA se aleatorizaron a una ventilación con un volumen corriente (VC) de 6ml/kg vs. 12ml/kg. En el momento en que se realizó el estudio, la práctica habitual era reducir el VC conforme bajaba la distensibilidad pulmonar y aumentaban las presiones de la vía aérea. Por lo tanto, la aleatorización generó un subgrupo de pacientes más graves en los que un VC de 12ml/kg resultaba excesivo, y un subgrupo de pacientes menos graves en los que un VC de 6ml/kg era inferior a la práctica habitual. Estudios posteriores mostraron que en los pacientes cuya distensibilidad prealeatorización era menor, el aumento del VC se asociaba a una mayor mortalidad en comparación con los pacientes tratados con volúmenes bajos (42% vs. 29%). Por el contrario, en los pacientes con mayor distensibilidad, la reducción del VC aumentaba la mortalidad (37% vs. 21%)100.

En estas condiciones, el efecto del tratamiento no se compara con los resultados de la práctica clínica real, sino con unas condiciones experimentales artificiales y no reflejan adecuadamente la efectividad real del tratamiento.

Personalización de la medicina crítica y medicina de precisiónLa medicina personalizada no es un descubrimiento reciente. La estratificación del riesgo y el desarrollo de reglas de predicción clínica tienen una larga tradición en la medicina intensiva y han facilitado la identificación de grupos relativamente homogéneos de pacientes y el establecimiento de recomendaciones ajustadas al riesgo-beneficio individual87,101. En los últimos años, la personalización del tratamiento se ha beneficiado del desarrollo de marcadores biológicos, tanto pronósticos como de respuesta al tratamiento102,103.

Un grado más de profundización en la personalización del tratamiento sería la prescripción de forma «precisa» sobre la base de las características genéticas, proteómicas y metabolómicas individuales («medicina de precisión»)104. Esta corriente ha tenido éxitos notables en algunas disciplinas, especialmente la oncología (v.g. cáncer de mama her-2 positivo, cáncer de pulmón EGFR positivo, etc.). Estos avances han generado expectativas de que la medicina de precisión permita identificar dianas terapéuticas y obtener grupos homogéneos de pacientes críticos, evitando así los falsos negativos debidos a la inclusión de pacientes que no se pueden beneficiar del tratamiento104.

Esta idea ha sido recibida con entusiasmo por algunos investigadores que consideran que la raíz de los fiascos de los EEC en medicina intensiva está en el carácter proteiforme de la patología crítica y la heterogeneidad de la respuesta a los tratamientos, y proponen una reorientación de la investigación hacia la medicina de precisión. Con frecuencia esta propuesta se acompaña de una defensa de la supremacía del razonamiento fisiopatológico y de la generación de nueva evidencia a partir de los datos asistenciales (big data) frente a la evidencia procedente de ensayos aleatorizados17,25,27.

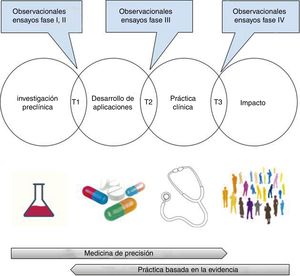

En este punto hay que hacer algunas matizaciones. En primer lugar, la oposición entre una medicina de precisión —basada en la fisiopatología y en las características individuales del paciente— y una medicina basada en la evidencia —obtenida a partir de grupos de pacientes— es solo aparente105, ya que ambas se necesitan mutuamente. En efecto, entre los hallazgos prometedores de la investigación preclínica y su integración en la práctica clínica se requiere una valoración de la validez (analítica y clínica) y de la utilidad clínica de las posibles aplicaciones (test o tratamientos)106. Este proceso traslacional, que va más allá del paradigma bench-to-bedside, incluye necesariamente la realización de ensayos clínicos aleatorizados, investigación de síntesis (revisiones sistemáticas, metaanálisis, análisis de decisiones) y elaboración de guías de práctica clínica basadas en la evidencia107-110 (fig. 3). El conocimiento de la fisiopatología es crucial para un correcto diseño de los ensayos aleatorizados, así como para valorar la plausibilidad biológica de los hallazgos de la investigación clínica27,111,112; sin embargo, hay que recordar que su uso exclusivo para la toma de decisiones ha generado importantes daños en los pacientes, que solo se han puesto de manifiesto con ensayos aleatorizados amplios19-23,73,113 (tabla 1).

Investigación traslacional: del laboratorio al impacto en salud.

T1-T3: investigación traslacional tipo 1-tipo 3.

Imágenes obtenidas bajo licencia CC0 a través de pixabay (https://pixabay.com).

En segundo lugar, la era de la medicina de precisión no ha llegado todavía a la medicina intensiva32 y aún tendría que superar algunos problemas antes de ser aceptada como una propuesta viable104,114,115. Las dificultades para obtener biomarcadores predictivos de respuesta al tratamiento en la práctica clínica son notables, especialmente en las condiciones fisiopatológicas rápidamente cambiantes del enfermo crítico. Por ejemplo, a pesar de las más de 1.000 publicaciones existentes sobre polimorfirmos genéticos en la sepsis no se ha encontrado un test diagnóstico suficientemente válido y disponible a pie de cama que empareje un genotipo específico con su terapia correspondiente104. Por otra parte, el cuerpo de evidencia disponible en este campo presenta importantes debilidades: gran parte de los estudios se basan en el hallazgo de valores de p significativos sin hipótesis previas; frecuentemente utilizan muestras de conveniencia con alto riesgo de sesgo de selección, y adolecen de un insuficiente control de variables de confusión y una escasa tasa de reproducibilidad6. Respecto a su viabilidad, la infraestructura informática y la base legal ineludible para gestionar los datos necesarios para una medicina crítica de precisión es a fecha de hoy claramente insuficiente29,104 y existen serias dudas sobre su sostenibilidad económica; prueba de ello es la reciente decisión del Medicare y Medicaid de no reembolsar la prescripción farmacogenómica de warfarina, a pesar del beneficio aportado a un pequeño grupo de pacientes con la variante genómica116. Finalmente, lejos de obviar los problemas logísticos de los macroensayos, la necesidad inherente a la medicina de precisión de evaluar tratamientos individualizados, supone estrechar cada vez más los criterios de inclusión, con la consiguiente ralentización de los tiempos de reclutamiento y un aumento de los costes de ejecución104.

Por todo ello, el desarrollo de la medicina de precisión en cuidados intensivos no debería paralizar la realización de nuevos y mejores ensayos clínicos117,118.

Mejores estudios clínicosLos ensayos aleatorizados —y de forma especial los realizados en pacientes críticos— tienen limitaciones como su alejamiento del «mundo real» (debido a los criterios estrictos de selección, el entorno académico y la protocolización del tratamiento) y las dificultades (legales y logísticas) para reclutar una muestra suficiente17,119.

El alejamiento de la práctica clínica real de los ensayos clínicos genera un problema de validez externa, que se ha intentado paliar mediante el diseño de ensayos pragmáticos. A diferencia de los ensayos explicativos (o ensayos de eficacia), orientados a maximizar las posibilidades de que un tratamiento demuestre su efecto, los estudios pragmáticos (o ensayos de efectividad) se orientan a evaluar el efecto de la intervención en condiciones de la práctica clínica, lo que les dota de una mayor representatividad y cierta información sobre la efectividad real de la intervención (tabla 2)120.

Características de los estudios de eficacia frente a estudios de efectividad

| Ensayo explicativo | Ensayo pragmático | |

|---|---|---|

| Objetivo | Determinar eficacia | Determinar efectividad |

| Contexto | Investigadores profesionales | Práctica clínica habitual |

| Criterios de selección | Estrictos (prima validez interna) | Amplios (prima validez externa) |

| Tamaño muestral | Generalmente medio-bajo | Alto (miles de pacientes) |

| Desenlaces | Frecuentemente intermedios | Desenlaces relevantes para el paciente |

Por su parte, los metaanálisis de datos individuales ofrecen una oportunidad para explorar subgrupos homogéneos de pacientes con mayor potencia estadística sin renunciar a las técnicas de ajuste tradicionales35.

Cuando no existen ensayos aleatorizados, los ensayos disponible son de baja calidad121 o carecen del poder estadístico suficiente (p. ej., para detectar eventos raros), los estudios observacionales basados en análisis secundarios de registros pueden ser adecuados; sin embargo, estos estudios están limitados por la calidad y el número de variables recogidas122. Por otro lado, los estudios observacionales adolecen del problema de la confusión por indicación (los pacientes pertenecientes a los grupos experimental y control tienen pronósticos de partida diferentes debido a variables de confusión conocidas o desconocidas). El ajuste estadístico mediante puntuación de propensión al tratamiento proporciona en general resultados consistentes con los de los ensayos aleatorizados; sin embargo, en ocasiones, los resultados son contradictorios, sin que exista ninguna forma fiable de predecir estos desacuerdos123. Por todo ello, los estudios observacionales no parecen adecuados para evaluar intervenciones con un efecto pequeño124,125.

Recientemente se han desarrollado nuevas modalidades de ensayos clínicos, que en ciertos casos podrían paliar estas limitaciones. Aquí hay que citar los ensayos cruzados binarios con datos agregados (cluster randomized crossover trials), con un gran potencial para la evaluación de intervenciones habituales en cuidados intensivos para reducir la mortalidad126-129.

Por su parte, el ensayo clínico con asignación aleatoria de cohorte múltiple (cohort multiple randomised controlled trial) combina las fortalezas del ensayo aleatorizado —validez interna— y las del registro observacional —muestreo consecutivo representativo, comparación con la práctica clínica real, ampliación del reclutamiento, reducción de costes125,130. Este tipo de diseño podría beneficiarse, además, de la recogida de datos en tiempo real a través de sistemas de vigilancia electrónica («sniffers») —una tecnología que notifica rápidamente al investigador la existencia de un paciente con criterios de inclusión, lo que ha permitido doblar la velocidad de reclutamiento en un ensayo de sepsis131.

Por último, los nuevos diseños adaptativos podrían ser especialmente útiles si se sospecha un efecto de subgrupo (marcadores de susceptibilidad)132. Este diseño se está utilizando en un amplio estudio europeo de la neumonía adquirida en la comunidad (AD-SCAP) para probar diversas combinaciones de antibióticos, esteroides y estrategias de ventilación (ClinicalTrials.gov NCT02735707). Mediante un procedimiento complejo basado en grandes cantidades de datos, una plataforma informática asigna de forma adaptativa a los pacientes con rasgos distintivos de enfermedad a las terapias más prometedoras para su perfil. Estas características indican que los ensayos de plataforma podrían servir como un primer paso hacia la medicina de precisión, ya que se inscriben en un grupo heterogéneo de pacientes, pero permiten el análisis de subtipos específicos en tiempo real, disminuyendo los falsos negativos debidos a los efectos diferenciales del tratamiento.

CorolarioLos resultados de la investigación clínica en el paciente crítico en las últimas décadas distan mucho de las expectativas que habían generado. Ello se debe tanto a las singularidades del entorno del paciente crítico como a deficiencias mejorables en la cadena de la investigación. El futuro desarrollo de una hipotética medicina crítica de precisión es esperanzador, pero entre tanto se avanza en esta línea, se debería tomar medidas para no seguir malgastando los esfuerzos de la investigación9,10,133-135(tabla 3).

Iniciativas para mejorar la relevancia, la calidad y la difusión de la investigación clínica

| Iniciativa/recursos | Objetivo |

|---|---|

| James Lind41 https://www.ncbi.nlm.nih.gov/pmc/articles/PMC539653/ | Promover mejores ensayos clínicos: nuevos ensayos en contexto de revisiones sistemáticas; participación de pacientes en la priorización; participación en ensayos relevantes |

| https://clinicaltrials.gov/ https://www.clinicaltrialsregister.eu/ http://www.who.int/ictrp/en/ http://www.hkuctr.com/ https://www.crd.york.ac.uk/PROSPERO/ | Registros de ensayos y revisiones sistemáticas |

| CASP International CASP España http://www.redcaspe.org/ | Formación en lectura crítica de la literatura biomédica |

| GRADE http://www.gradeworkinggroup.org/ | Desarrollo de metodología rigurosa para la elaboración de guías de práctica clínica |

| Alltrials75 http://www.alltrials.net/ | Promover la publicación de toda la investigación clínica |

| EQUATOR http://www.equator-network.org/ | Guías para la publicación transparente de la investigación |

| Evidence Alerts https://plus.mcmaster.ca/EvidenceAlerts/ | Difusión selectiva de artículos válidos y relevantes |

| Antimicrobial Stewardships Programs https://www.cdc.gov/getsmart/healthcare/implementation/core-elements.html | Mejora de la utilización de antimicrobianos |

J. Latour es miembro de CASP-España.

A Juan B. Cabello, Vicente Gómez-Tello, Ana Llamas, Eva de Miguel, Juan Simó y José Antonio Viedma por la lectura crítica de una versión anterior del manuscrito. Procede la eximente habitual.